L’Autorité fédérale de surveillance des marchés financiers FINMA a mené une enquête auprès de quelque 400 établissements financiers suisses sur l’utilisation de l’intelligence artificielle (IA). Que ce soit sous la forme de chatbots comme ChatGPT, dans l’optimisation des processus ou dans la rédaction de textes: environ la moitié des établissements interrogés utilisent l’IA dans leur travail quotidien.

De fin novembre 2024 à mi-janvier 2025, la FINMA a interrogé environ 400 de ses assujettis (banques et maisons de titres, assurances et intermédiaires d’assurance, directions de fonds, gestionnaires de fortune collective et infrastructures du marché financier) sur l’utilisation de l’IA. Les résultats de l’enquête montrent que les établissements financiers suisses misent de plus en plus sur l’IA.

La moitié des établissements interrogés utilisent l’IA

Environ 50 % des établissements interrogés par la FINMA utilisent l’IA ou ont de premières applications en cours de développement. Un autre quart a l’intention de recourir à l’IA au cours des trois prochaines années. En moyenne, les personnes interrogées ont environ cinq applications en service et neuf en cours de développement. Les grandes entreprises ont tendance à utiliser plus d’applications que les petites. 91 % des sondés qui recourent à l’IA exploitent également l’IA générative et de nouveaux chatbots. La dépendance à l’égard de prestataires BigTech augmente de ce fait. La plupart des établissements ne misent pas uniquement sur leurs propres développements et ont également recours à des prestataires externes. Les petits établissements s’appuient souvent exclusivement sur les applications développées par des tiers. Dans son monitorage de risques 2024, la FINMA attire l’attention sur les risques d’externalisation. L’externalisation de fonctions critiques à des prestataires tiers reste une source centrale de risques opérationnels dans le secteur financier.

Gouvernance et stratégie en matière d’IA

Environ 50 % des établissements ont intégré l’utilisation de l’IA dans une stratégie explicite en la matière. Lorsqu’il s’agit d’appliquer les cadres de gouvernance existants, beaucoup se concentrent sur la protection des données, la sécurité informatique et la cybersécurité, la gestion des données et la gestion des risques d’entreprise. S’agissant des risques de l’IA, la priorité est donnée à la qualité des données, à la protection des données et à l’explicabilité. En outre, une importance accrue est accordée aux risques liés à la sécurité des données, à l’exactitude lacunaire et aux risques d’externalisation.

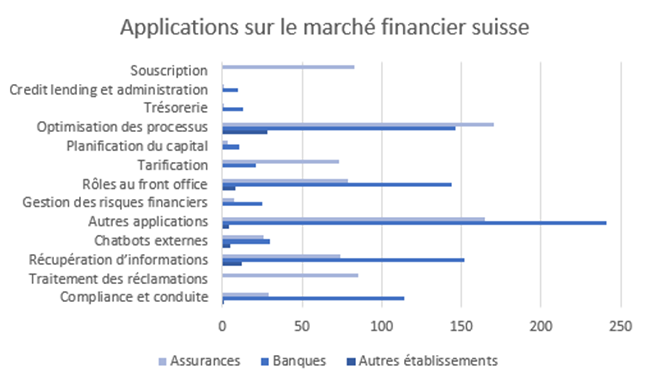

Nombre d’applications cumulé sur l’ensemble des établissements interrogés. Parmi les 187 établissements autorisés qui recourent à l’IA, 75 assurances et intermédiaires d’assurance appartiennent à la catégorie «Assurances», 100 banques et maisons de titres à la catégorie «Banques» et 12 directions de fonds, gestionnaires de fortune collective et infrastructures des marchés financiers à la catégorie «Autres établissements».

Une surveillance neutre sur le plan technologique : «same business, same risks, same rules»

Conformément à ses priorités relatives à la mise en œuvre des objectifs stratégiques (2025-2028), la FINMA garantit, par son activité d’autorisation et de surveillance transparente et neutre à l’égard de la technologie, que les technologies nouvelles et innovantes peuvent être utilisées dans le respect du cadre réglementaire sur le marché financier suisse. Dans ce contexte, la FINMA suit l’approche «same business, same risks, same rules». L’objectif de cette enquête était de suivre l’évolution de l’utilisation de l’IA ainsi que la gouvernance et la gestion des risques qui y sont liées, et ce, afin de garantir une approche de la surveillance axée sur les risques.

Dans sa communication sur la surveillance 08/2024, la FINMA a partagé ses observations en matière de surveillance concernant la gouvernance et la gestion des risques liés à l’utilisation de l’intelligence artificielle. Pour l’avenir, la FINMA recommande aux établissements autorisés de prendre contact avec elle suffisamment tôt s’ils envisagent d’utiliser l’IA pour des processus critiques ou dans le cadre du calcul de valeurs prescrites par la réglementation.